Мадам де Монтеспан: история истинной королевы Франции

Если Диана де Пуатье правила из тени, опираясь на личную преданность короля, то эпоха «Короля-Солнца» Людовика XIV потребовала иного масштаба. Здесь фаворитизм перестал быть тайной. И самой яркой звездой на этом небосклоне стала Франсуаза-Атенаис де Монтеспан - женщина, которую современники называли «истинной королевой Франции».

Рождение звезды

Франсуаза де Рошешуар де Мортемар ( Атенаис) появилась на свет 5 октября 1640 года в замке Люссак-ле-Шато и происходила из одного самых старинных аристократических родов Франции - дома Рошешуаров. Ее отец, Габриель де Рошешуар, маркиз де Мортемар, дал ей аристократическую гордость и знаменитое фамильное остроумие, которым так славились Мортемары. Мать, Диана де Грансень, была фрейлиной самой Анны Австрийской и сумела обеспечить дочери место при дворе.

При крещении девочку назвали Франсуазой, но позже, увлекшись модным тогда прециозным стилем, она добавит себе имя Атенаис - в честь мудрой греческой богини. Это имя удивительно точно отражало ее натуру. Атенаис действительно была умна, и ум ее был политическим. Вольтер позже писал, что она и ее сестры «были самыми красивыми женщинами своего времени» и славились «особым складом ума - шутливым, простодушным и хитроумным», который считался фирменным знаком их рода.

В 20 лет Франсуаза стала фрейлиной Генриетты Стюарт, супруги брата короля и потом, при поддержке матери, перешла ко двору королевы Марии-Терезии Испанской - жены Людовика XIV. В 1663 году она вышла замуж за Луи-Анри де Пардайана, маркиза де Монтеспана. Брак оказался неудачным: муж был заядлым картежником и транжирой.

Восхождение звезды

В 1666 году Людовик XIV был увлечен кроткой и набожной Луизой де Лавальер, своей первой официальной фавориткой. Но Лавальер была грустной, задумчивой и, что самое важное для двора, почти никому не протежировала. Таких фавориток не любят, ведь от них нет пользы.

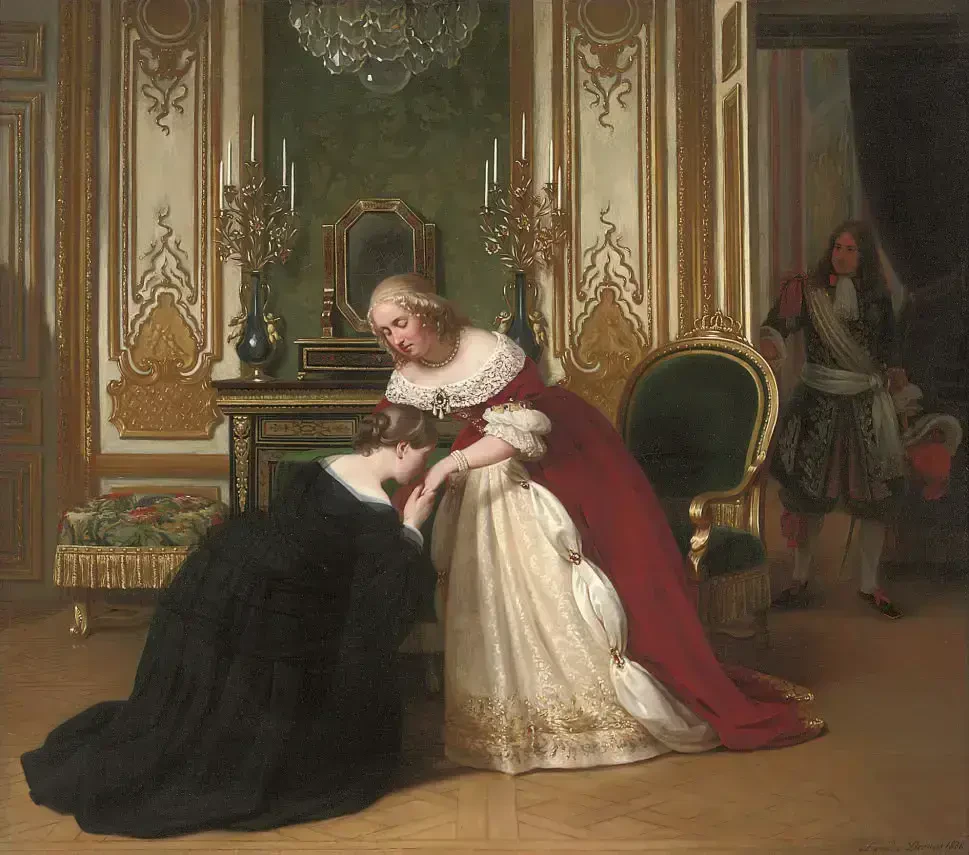

Франсуаза, появившись при дворе, быстро поняла механизм успеха. Она не стала соперничать с Лавальер открыто, а стала ее лучшей подругой. Луиза, страдавшая от одиночества, доверчиво рассказывала новой приятельнице все тайны и с восторгом говорила о ней королю. Так Монтеспан оказалась в поле зрения Людовика, но пока оставалась лишь интересной собеседницей.

Все изменилось во время похода во Фландрию в 1667 году. Пока две беременные женщины короля, королева и официальная фаворитка, оставались во Франции, Монтеспан отправилась с королем на войну. Однажды вечером, зная, что король наблюдает за ней во время купания, Франсуаза «случайно» уронила полотенце, что пробудило в короле новые чувства. С этого момента Лавальер была обречена. Еще год Людовик пытался сохранять видимость отношений с Луизой, но сердце его уже принадлежало обольстительной Атенаис. На одном из придворных праздников король появился с эмблемой: на лазоревом поле сияла алмазная звезда в окружении множества малых звезд и девизом: «Блистательнейшей и прекраснейшей». Всем было ясно, кто эта главная звезда.

Кроткая Лавальер, поняв, что все кончено, уйдет в монастырь кармелиток, где проведет 36 лет, вымаливая прощение за грехи.

20 комнат против 10 королевских

Мадам де Монтеспан стала официальной фавориткой в 1667 году и оставалась ею до 1683-го. Это была эпоха абсолютного триумфа. В эпоху абсолютизма, когда король сам был солнцем, фаворитка являлась отражением королевского блеска: чем ярче сияла она, тем могущественнее выглядел он.

В Версале мадам де Монтеспан занимала 20 комнат - это ровно в два раза больше, чем законная королева. У нее был собственный «двор», где министры, генералы и послы считали за честь быть принятыми. Ее ливрея, ее выезды, ее приемы соперничали с королевскими. Она стала живым воплощением могущества монарха, который мог позволить себе вознести простую смертную (пусть и аристократку) выше законной супруги.

Ее аппетиты поражали придворных. Генеральный контролер финансов Кольбер хватался за голову, пытаясь покрыть ее расходы. По требованию Атенаис ей был предоставлен собственный флот и даже живые медведи, которых фаворитка поселила в Версальском дворце.

Однажды она проиграла в карты около 5 миллионов ливров. Для понимания: годовой бюджет всего французского флота в то время составлял 12,5 миллионов. Королевская казна оплачивала ее долги, а также строительство замков (она забраковала один построенный для нее дворец, заявив, что он годится разве что для оперной певички, и велела сломать его и построить заново).

Именно Монтеспан привила Людовику вкус к роскошным излишествам, дала импульс развитию французской торговли и производства тканей, кружев, ювелирных изделий. Министр Кольбер говорил: «Мода была для Франции тем же, чем шахты Перу для Испании» . И мадам де Монтеспан была главным законодателем этой моды.

За 13 лет связи мадам де Монтеспан родила Людовику XIV семерых детей. Четверо из них дожили до зрелого возраста и были узаконены королем: Луи-Огюст, герцог Мэнский; Луи-Сезар, граф де Вексен; Луи-Александр, граф Тулузский; и Франсуаза-Мария, мадемуазель де Блуа. Все они получили титулы и впоследствии породнились с королевскими домами Европы.

Для их воспитания мадам де Монтеспан наняла гувернантку - скромную вдову поэта Скарона, Франсуазу д'Обинье. С иронией судьбы эта женщина, призванная заботиться о детях, со временем станет главной соперницей Атенаис и войдет в историю как маркиза де Ментенон - тайная супруга Короля-Солнца.

Как и подобает истинной правительнице эпохи барокко, Монтеспан покровительствовала искусствам. При ее дворе блистали драматурги (она поддерживала Мольера и Расина), поэты и художники. Она собирала библиотеку, заказывала картины, покровительствовала музыкантам. В 1674 году король построил для нее великолепный замок Кланьи - символ ее могущества и его любви.

Падение звезды

С годами Людовик стал охладевать к страстной, властной и требовательной фаворитке. Появились юные соперницы, например, Анжелика де Фонтанж, прославившаяся особой прической. Ревность и страх потерять все толкнули мадам де Монтеспан на путь, который станет для нее роковым.

В конце 1670-х годов Париж потрясла серия громких арестов, вошедшая в историю как «Дело об отравителях». Вскрылась целая сеть колдуний, отравительниц и торговцев ядами. Центральной фигурой этого мрачного дела стала повитуха и знахарка Катрин Вуазен.

Под пытками Вуазен и ее сообщники (аббат Гибур) дали показания, которые повергли короля в ужас. Они утверждали, что мадам де Монтеспан неоднократно заказывала им проведение «черных месс» с участием младенцев, чтобы приворожить короля и даже избавиться от соперниц. Историки до сих пор спорят, насколько серьезны были эти обвинения. Скорее всего, Монтеспан действительно покупала любовные зелья и, возможно, участвовала в оккультных обрядах (что для того времени было страшным грехом и преступлением), но вряд ли замышляла убийство самого Людовика, ведь это было ей абсолютно невыгодно.

Тем не менее, скандал был колоссальным. Король приказал прекратить следствие по линии, касающейся фаворитки, изъять все компрометирующие документы и замять дело, чтобы не пятнать свое имя. Но доверие было подорвано навсегда. Хотя номинально Монтеспан оставалась при дворе и даже сохраняла титул фаворитки, доступ к телу и сердцу короля был для нее закрыт. Людовик все больше времени проводил с мадам де Ментенон - набожной, серьезной и спокойной женщиной, которая стала для него не столько любовницей, сколько сиделкой и советчицей в стареющие годы.

В 1691 году после смерти мужа маркиза де Монтеспан окончательно оставила двор. Она удалилась в монастырь Сен-Жозеф в Париже, а затем на воды в Бурбон-л'Аршамбо, где и скончалась 27 мая 1707 года в возрасте 66 лет.

Эпилог

Мадам де Монтеспан вошла в историю как яркая, расточительная, скандальная и при этом невероятно притягательная фаворитка, отличающаяся гедонистическою властью.

Ее фигура знаменует собой важный этап в эволюции фаворитизма. При Людовике XIV любовница короля перестала быть тайной - она стала частью государственного мифа. Ее роскошь была рекламой могущества Франции, ее остроумие - украшением двора, ее дети - доказательством божественной природы королевской власти, которая не стесняется своих плодов. Она была «истинной королевой» в той мере, в какой сам король был истинным Солнцем.